いつも忘れちゃうので、Node.jsをアップデートする手順をまとめておきます。

1.Homebrew

2.nodebrew

3.Node.js

上から順にアップデートしていきます。

1.Homebrewのアップデート

Homebewはパッケージ管理ツールで、ここからいろんなツールをダウンロードしたり、アップデートできます。

ターミナルで現在のバージョンを確認

brew -v

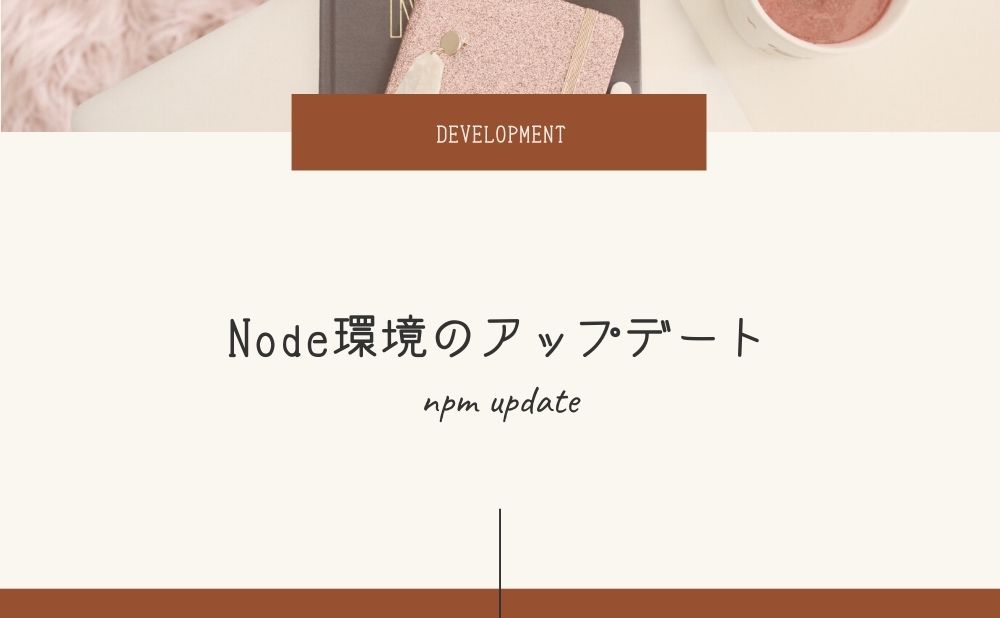

Homebrew 3.2.5

Homebrew/homebrew-core (git revision 9adb96828d; last commit 2021-07-28)HomebrewのReleaseから、最新版を確認します。

記事を作成した時点では、3.2.6になっていました。

brew updateでアップデートします。

brew update再度バージョンを確認すると、verが上がっています

brew -v

Homebrew 3.2.6

Homebrew/homebrew-core (git revision 23f4adf4c4; last commit 2021-08-03)2.nodebrewのアップデート

nodebrewはNode.jsのバージョン管理ツール。

Node.jsは、nodebrewからアップデートします。

複数のバージョンのNode.jsをインストールしたり、切り替え等々ができます。

バージョンの確認

nodebrew -v

nodebrew 1.0.1Nodebrewから、最新版のバージョンを確認できます。

brew upgrade nodebrewでアップデート

brew upgrade nodebrew3.Node.jsのアップデート

現在のバージョン確認

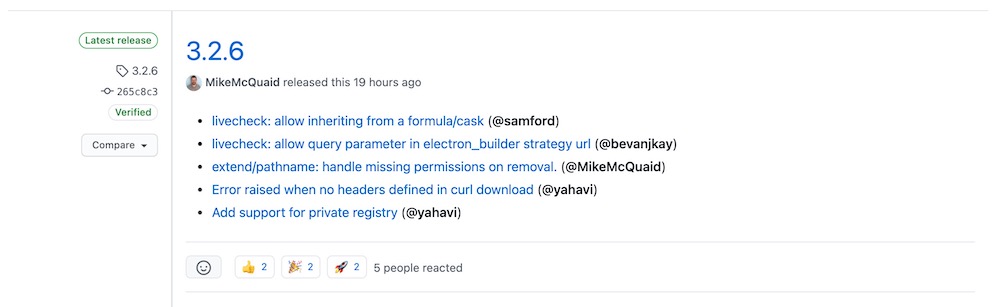

node -vNodebrewから、最新版のバージョンを確認できます。

最新バージョンを指定して、インストールします。

nodebrew install-binary v14.17.3使用できるバージョンをリストアップし、最新バージョンをセットします

nodebrew list

v12.16.1

v14.17.3

nodebrew use v14.17.3| コマンド | 説明 |

| nodebrew use latest | 最新版を有効化 |

| nodebrew use stable | 安定版を有効化 |

| nodebrew use v12.16 | v12.16.2 を有効化(vは省略可能) |

nodebrew ls

v12.16.1

v14.17.3

current: v14.17.3currentに最新版が指定されているのでOK!

余談:Use of uninitialized value $a1 in numeric comparisonエラー

私の場合、nodebrew lsのときにエラーが出ました。

$ nodebrew ls

Use of uninitialized value $a1 in numeric comparison (<=>) at /Users/nakatan/.nodebrew/current/bin/nodebrew line 678.

Use of uninitialized value $a1 in numeric comparison (<=>) at /Users/nakatan/.nodebrew/current/bin/nodebrew line 678.

.DS_Store

v12.16.1

v14.17.3.DS_Storeが含まれていると、このエラーがでるようです。

下記コマンドで.DS_Storeファイルを削除するとエラーがなくなりました。

$ rm ~/.nodebrew/node/.DS_Store

# or

$ rm /usr/local/var/nodebrew/node/.DS_Store